Auto-Updating Text | Automatisierte Texte + Produktbeschreibungen

Google launcht AI Overviews in Deutschland. 5 Thesen zur LLM Suche

Lesezeit 15 mins | 25.03.2024 | Von: Robert Weißgraeber

Als größte Suchmaschine und wichtigste Traffic-Quelle sind Googles Richtlinien ein sehr relevanter Teil der täglichen Diskussion für Marketeers und SEOs. Mit der Stellungnahme von Google-Manager John Müller zu “KI-generierten Inhalten” und deren Auswirkungen auf Websites kommt immer wieder die Frage auf, ob automatisch generierte Texte von Googles Webspam-Team abgestraft werden.

Die Kurzfassung vorab: Der Mehrwert für den User entscheidet, ob Google Websites mit automatisiert erzeugten Texten abstraft oder nicht. Auch die aktuelle Welle von AI-Generierungstools hat keinen Einfluss auf diesen Grundsatz. Daher ist es aus SEO-Sicht kein Problem, mit AX Semantics erzeugte Texte (auch in sehr großen Stückzahlen) auf Websites zu veröffentlichen, solange sie den bekannten Qualitätsstandards entsprechen.

Die neuesten Entwicklungen zur Thematik rund um automatisierten Texten, Google und den aktuellen Entwicklungen, liest du in unserem Ticker:

April 2025: Google laucht AI Overviews auch in Deutschland

5 Thesen zur LLM-Suche – und warum Sie jetzt schon einen VP of GAIO / LLMO / GEO haben sollten

Wenn wir über LLM-Suche sprechen, geht es um Suchintentionen, die auf LLM-basierte Produkte wie ChatGPT Search, Google SGE (auch bekannt als AI Overviews) oder Perplexity (bekannt dafür, als erstes eine dedizierte Produktsuche angeboten zu haben – https://www.theverge.com/2024/11/18/24299574/perplexity-ai-search-engine-buy-products) abzielen.

Diese Suchmaschinen liefern typischerweise eine schriftliche Zusammenfassung zum Thema, die Fakten und Argumente enthält, die zur Suchintention passen, und dabei Quellenangaben macht und/oder weiterführende Links bietet. Neben dem „gespeicherten“ Wissen im LLM (basierend auf den Textkorpora, auf denen es trainiert wurde) durchsuchen diese Produkte mittlerweile auch (live) das Web.

Inzwischen haben Unternehmen festgestellt, dass der eingehende Webtraffic über einige dieser Tools den Traffic über kleinere, etablierte Suchmaschinen übertrifft – etwa erhält ein Unternehmen inzwischen mehr Besucher über ChatGPT als über Bing.

Was bedeutet das also? Hier sind 5 Thesen:

1. LLMs werden als hilfreich wahrgenommen

Nutzer empfinden diese Tools als hilfreich – sonst würden sie sie nicht verwenden. Halluzinationen sind natürlich ein Problem, und manche Nutzer wissen das vielleicht nicht, aber insgesamt wird die Erfahrung als positiv bewertet. Andernfalls würde die Nutzung nicht weiter zunehmen. Gleichzeitig sehen wir aber, dass Nutzer die angegebenen Quellen besuchen – zur Vertiefung oder um die Antwort zu überprüfen. Andernfalls gäbe es keinen nennenswerten Traffic zu den zitierten Quellen.

2. Die Art der Ergebnisse hat sich verändert – die Nutzung bleibt ähnlich

Die klassische Suchergebnisseite (SERP), wie wir sie von Google mit einer Linkliste kannten, ist verschwunden. (Genauer gesagt: Sie ist schon seit 2018 mit all den „Featured Snippets“ und anderen integrierten Ergebnistypen (Produkte, Bilder, News...) verschwunden – siehe: https://zissou.pacific.co/blog/google-serp-history-upcoming-changes-and-their-impact-in-2024).

Aber die Nutzungsweise bleibt: Nutzer lesen die Zusammenfassung (früher: die Linktitel und Snippets), klicken auf Zitate (früher: Links), stellen Folgefragen (früher: neue Suchanfragen), und wenn sie zufrieden sind, beenden sie die Suche.

3. Die Nutzung explodiert

Wenn Sie noch Google oder Bing nutzen, sollten Sie Ihr eigenes Verhalten nicht als Maßstab für den allgemeinen Trend nehmen. Eine über 16 Jahre alte Suchmaschine wie Bing zu überholen, ist kein Pappenstiel. Ja, Google hat in der EU immer noch 20-mal mehr Nutzer als ChatGPT (https://searchengineland.com/chatgpt-search-41-million-average-monthly-users-eu-454478), aber mit dem Aufkommen von Googles AI Overviews wird sich das Verhältnis der durch LLM beantworteten Suchanfragen drastisch verändern.

Hören Sie sich einmal um: Wie viele Menschen in Ihrem Umfeld nutzen ChatGPT & Co als erste Anlaufstelle für jede Frage?

Selbst skeptische Nutzer geben inzwischen zu, dass sie LLM-basierte Suche immer häufiger verwenden – nicht nur für Freizeit oder unwichtige Aufgaben, sondern auch im beruflichen Alltag. Wie immer gilt: Jüngere Generationen übernehmen neue Technologien schneller.

4. Die meisten Suchanfragen erfolgen nicht mehr in Suchmaschinen, sondern „in Kontext“, in Apps

LLM-basierte Antwortsysteme werden in jede erdenkliche Anwendung integriert. Das verändert grundlegend, wie wir das Web nutzen. Anstatt unsere Reise im Browser mit der bekannten Google-Suchleiste zu beginnen, erhalten wir Antworten direkt in der Anwendung, die wir gerade nutzen – z. B. bekommt ein Entwickler relevante Infos (z. B. von Stack Overflow), ohne „zu googeln“, direkt in seinem Editor (VS Code, Emacs, …).

(Das wird auch unsere Browsernutzung verändern: Vielleicht öffnen wir bald keine Browserfenster mehr, sondern bewegen uns in Anwendungen, und bekommen Webinhalte nur noch als Pop-up oder eingebettete Antwort im LLM.)

So ein großer Sprung ist das nicht: Plattformen wie TikTok oder Instagram verzeichnen schon heute riesige Suchvolumen – jetzt können sie mit LLMs auch echte Antworten liefern, nicht nur Ads oder Reels. Was das für bezahlte Links (z. B. AdWords, SEA allgemein) bedeutet – also für das Geschäftsmodell, das Google zur größten Werbeplattform der Welt gemacht hat – wird sich zeigen.

5. Das Geschäftsmodell von Suchmaschinen wird grundlegend infrage gestellt

Auf den ersten Blick wird es deutlich: Wo sind die bezahlten Links? In der Ära der „10 blauen Links“ wurden die obersten Plätze verkauft – das lässt sich in LLM-Ergebnissen nicht so leicht replizieren. Denn LLMs müssen eine inhaltliche Perspektive wahren und die besten, informativsten Quellen hervorheben. Traffic gibt es nur für angeklickte Zitate – warum also für Inhalte zahlen, die gar nicht geklickt werden

Stattdessen entstehen neue Modelle, z. B. kostenpflichtige Abos, die nicht auf dem Verkauf persönlicher Daten basieren. Aber können diese Suchsysteme langfristig Erfolg haben? Das betrifft die gesamte Martech-Branche, mit ihren zahlreichen Softwareanbietern, Dienstleistern und Konzernabteilungen.

Andererseits sind LLM-Suchanfragen deutlich teurer als klassische Suchanfragen, was die Wirtschaftlichkeit drastisch verändert. Was übrig bleibt, wenn das VC-Geld und der Kampf um Marktanteile vorbei sind, ist unklar.

Der Wandel ist da – und er ist grundlegend

Auch wenn er sich (noch) nicht im Aktienkurs widerspiegelt: Das Internet hat sich für immer verändert. Es hat die Art und Weise, wie verschiedene Teile der Branche zusammenarbeiten – von Social Media über Browser bis zu Werbung und Business-Apps – tiefgreifend umgewälzt.

Und es wird den Traffic verändern, den Ihre Website bekommt.

Das Internet hat sich verändert.

Einige Dinge bleiben aber gleich.

Und diese Dinge sind grundlegend. Selbst wenn sich die Technologie und der Zugriff komplett verändern, muss sie weiterhin dem dienen, was die Nutzer wollen: Fragen beantworten, Ratschläge geben, weiterleiten…

LLM-basierte Suchsysteme müssen also dieselben Grundsätze wie klassische Suchmaschinen erfüllen: vertrauenswürdige Quellen erkennen, Spam herausfiltern, aktuell bleiben. Die Mechanismen – Page Rank, Autorität, Strafen, Crawling/Indexierung – mögen anders sein, aber das Ziel bleibt gleich.

(Für Website-Betreiber gilt das auch: Um „indexiert“ zu werden, muss der Inhalt technisch zugänglich sein (SEO), und er muss für den Leser wertvoll, einzigartig und autoritativ sein – nicht für den Ersteller.)

Dann kommt auch der Traffic. Falls nicht, muss man dafür zahlen. Der einzige Unterschied: Die Links heißen jetzt „Zitate“. Und SEO heißt jetzt vielleicht GAIO, GEO oder LLMO – wie genau, ist noch offen.

März 2024: Google Spam Update: “Scaled content abuse”

Kämpft Google JETZT gegen KI-Texte? Die Antwort lautet eindeutig: Nein! Google verstärkt lediglich das bereits bekannte Vorhaben, qualitativ hochwertigen, hilfreichen, also “helpful” Content zu fördern. Dahingehend versucht Google massenhaft spammy Content, der lediglich darauf abzielt, Rankings zu beeinflussen, zu unterbinden. Explizit beschrieben sind Maßnahmen gegen "in großem Umfang generierte Inhalte, die das alleinige Ziel haben Rankings zu beeinflußen" (“generate low-quality or unoriginal content at scale with the goal of manipulating search rankings”).

Google straft also nicht per se KI-Texte ab, sondern Texte, die keinen Mehrwert für die Nutzer beinhalten. Content-Verantwortliche haben die Aufgabe, fortschrittliche KI-Technologien nicht nur des Effizienz Willens einzusetzen, sondern deren Potenziale für qualitativ hochwertigen Content auszuschöpfen.

Die Entwicklung in der Texterstellung ähnelt zunehmend einer fortschrittlichen Produktion, bei der Automatisierungstools mit integrierten KI-Anwendungen wie ChatGPT und DeepL entscheidend sind, um nicht nur die Menge, sondern vor allem die Qualität der Inhalte zu steigern. Diese "Intellektuelle Revolution", vergleichbar mit der industriellen Revolution in Bezug auf Produktionsprozesse, ermöglicht eine innovative Herangehensweise an die Texterstellung.

Entscheidend ist dabei, KI nicht zur Manipulation von Suchrankings durch die Erstellung von quantitativem, qualitativ willkürlichen Content zu missbrauchen. Wie es tatsächlich der Fall ist, wenn generative KI-Entwürfe (GPT generierte Entwürfe) nicht redigiert veröffentlicht werden. Stattdessen sollten die Inhalte durch tiefgreifendes Fachwissen, Aktualität und Anpassungsfähigkeit an unterschiedliche Medien und Plattformen aufgewertet werden. Automatisierung ermöglicht es, Inhalte kontinuierlich aktuell zu halten und präzise auf die Bedürfnisse der Zielgruppe abzustimmen.

Daher liegt der Fokus nicht allein auf der Menge des Contents, sondern vielmehr auf dessen Qualität und Relevanz. Eine umfassende Automatisierung, die über die reine Erstellung von Entwürfen hinausgeht, ist essentiell, um diesen Anforderungen gerecht zu werden und effiziente sowie skalierbare Text-Produktionsprozesse zu etablieren.

In diesem neuen Zeitalter der Texterstellung ist es für Unternehmen, die geschickt Automatisierung in Kombination mit KI nutzen, möglich, sich mit hochwertigem, ansprechendem und für Google optimiertem Content von der Konkurrenz abzuheben. Mehr Informationen

August 2023: Google ändert Rich-Suchergebnisse für Anleitungen und FAQs

Für viele SEOs war es eine unangenehme Nachricht: Google plant Änderungen an den Rich-Suchergebnissen für Anleitungen und FAQs, wie das Unternehmen selbst bekannt gibt. Diese Änderungen sollen die Suchergebnisse laut Google übersichtlicher machen. Rich-Suchergebnisse für FAQ werden demnach nur noch auf vertrauenswürdigen Behörden- und Gesundheitswebsites angezeigt.

Anleitungen in Rich-Suchergebnissen werden nur auf Desktop-Geräten angezeigt, vorausgesetzt, die mobile Version der Website enthält das entsprechende Markup. Die Änderungen betreffen die Verwendung strukturierter Daten auf den Websites.

Die Search Console-Berichte werden diese Änderungen widerspiegeln, haben jedoch keinen Einfluss auf die Anzahl der erfassten Elemente. Die Einführung der Änderungen erfolgt weltweit ab Mitte August 2023. In Panik sollten Website-Betreiber und SEOs aber nicht verfallen. Denn FAQ haben einen positiven Impact auf die Nutzererfahrung und Benutzerfreundlichkeit der Seite. Die Faustregel ist und bleibt: Inhalte sollten stets in erster Linie für Nutzer gedacht und erstellt werden.

Juni 2023: Google entwickelt Richtlinie für KI- und E-E-A-T-Inhalte

Auf der Google Search Central Live in Tokio 2023 gab es mehrere Diskussionen, insbesondere darüber, wie Google (zukünftig) mit Inhalten umgeht, die durch künstliche Intelligenz (KI) erzeugt werden. Hier sind die wichtigsten Kernpunkte:

- KI und Textqualität: Google macht keinen Unterschied zwischen KI-generierten Texten und von Menschen erstellten Inhalten. Der wichtigste Faktor für Google ist die Qualität des Inhalts, unabhängig von seiner Quelle.

- Kennzeichnung KI-generierter Inhalte: Google selbst kennzeichnet KI-generierte Inhalte nicht. Die Europäische Union fordert jedoch vor allem Social-Media-Unternehmen auf, solche Inhalte freiwillig zu kennzeichnen, um so zum Beispiel Fehlinformationen entgegenzuwirken.

- Verantwortung liegt bei Website-Betreibern: Während Google den Publishern derzeit empfiehlt, KI-generierte Bilder mit IPTC-Bilddaten-Metadaten zu kennzeichnen, sind sie dazu nicht verpflichtet. Google überlässt es ihnen zu entscheiden, ob es, z.B. für die Nutzererfahrung, besser ist.

- Überprüfung der KI-Inhalte: Google empfiehlt, KI-generierte Inhalte vor der Veröffentlichung von einem menschlichen Redakteur überprüfen zu lassen. Dies gilt auch für übersetzte Inhalte.

- Natürliches Content-Ranking: Die Algorithmen von Google basieren auf von Menschen erstellten Inhalten, daher werden solche „natürlichen“ Inhalte bevorzugt und besser ranken.

- KI-Inhalte und E-E-A-T (Expertise, Erfahrung, Autorität und Vertrauenswürdigkeit (Trustworthiness)): Google diskutiert derzeit intern, wie sich KI-Inhalte in den E-E-A-T-Modell einfügen, da KI nicht über persönliche Erfahrungen oder Fachwissen zu einem Thema verfügen kann. Google wird dazu zukünftig eine Richtlinie bekannt geben, sobald eine Entscheidung getroffen wurde.

- KI-Richtlinien entwickeln sich ständig weiter: Die Google-Richtlinien in Bezug auf KI-Inhalte werden sich aufgrund der zunehmenden Verfügbarkeit von KI und der Bedenken hinsichtlich ihrer Vertrauenswürdigkeit weiterentwickeln. Google rät den Publishern, sich in dieser Übergangszeit weiterhin auf die Qualität der Inhalte zu konzentrieren.

März 2023: Was ist Bard? - Eine kurze Einführung in Googles Chatbot

- Was ist Bard und wie funktioniert es?

Bard ist eine von Google entwickelte Conversational AI (Konversations-KI), die auf einer abgespeckten Version von LaMDA basiert. LaMDA ist Googles Sprachmodell, das mit Texten und Webdaten trainiert wurde, die zusammen aus 1,56 Billionen Wörter bestehen. So wie ChatGPT ist Bard in der Lage, textbasierte Antworten auf Fragen (Prompts) zu geben, Informationen aus dem Internet zusammenzufassen und Links zu relevanten Websites bereitzustellen. Dabei ist es wichtig festzuhalten, dass Bard keine Suchmaschine ist, sondern eine Funktion von dieser. Es ist ein interaktives Tool, um Themen zu erkunden und Nutzern zu helfen, sich über Sachverhalte zu informieren sowie ein breites Spektrum von Meinungen oder Perspektiven zu erkunden. - Wie wurde Bard trainiert?

Kurz gesagt: Bard wurde mit Webinformationen gefüttert, die es in Texte umwandelt. Die Antworten wurden durch Crowdsourcing anhand von Metriken wie Sinnhaftigkeit, Genauigkeit und Relevanz bewertet, um die Leistung des Chatbots zu verbessern. Es bleibt jedoch unklar, welche Werte und Überzeugungen die Crowdsourcing-Bewerter hatten, wie sie ausgwählt wurden und unter welchen individuellen bzw. subjektiven Gesichtspunkten sie die gegebenen Informationen ggf. bewerteten. - Warum hat Google einen eigenen Chatbot entwickelt?

Viele sehen Bard als Antwort auf ChatGPT von OpenAI und glauben, dass die übereilte Veröffentlichung von Bard von der Angst getrieben war, im technologischen Wettlauf hinter die Konkurrenz zurückzufallen. Einen Rückschlag erlitt Google ausgerechnnet bei der Markteinführung von Bard im Februar 2023, als der Chatbot während einer Demo einen sachlichen Fehler ausgab. Dies führte zu einem erheblichen Kurseinbruch der Unternehmensaktie.

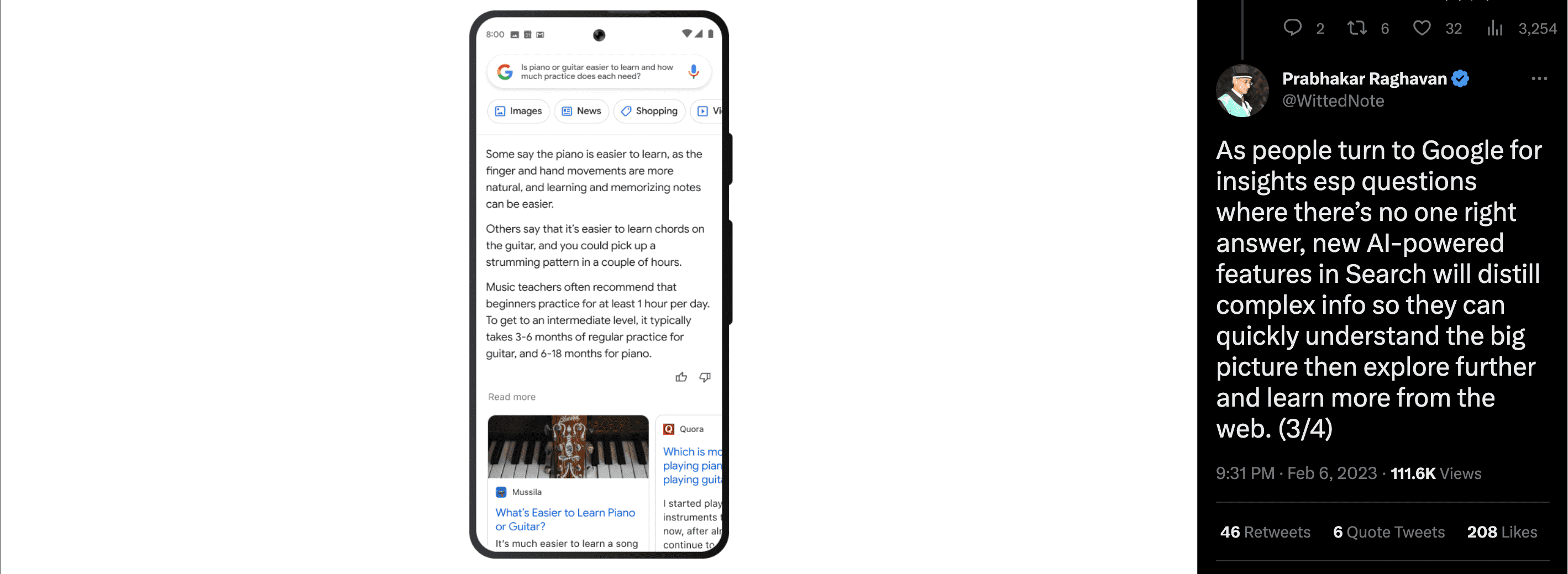

Langfristig sieht Google Bard als Teil einer Suchfunktion, die „komplexe Informationen und verschiedene Perspektiven in leicht verdauliche Formate destilliert“, wie es in der Ankündigung von Bard heißt. Google hat zudem kürzlich Forschungsergebnisse veröffentlicht, die darauf abzielen, große Sprachmodelle darauf zu trainieren, ihre Quellen zu zitieren, was für die Informationssuche von entscheidender Bedeutung sein dürfte – und nach derzeitigem Stand einen Vorteil gegenüber ChatGPT bringen würde.

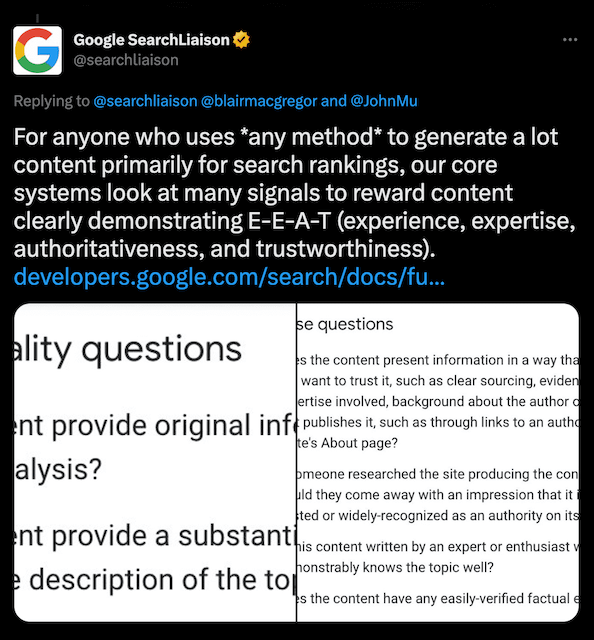

Februar 2023: "KI darf genutzt werden, um bessere Inhalte zu schreiben"

Du lässt deine Inhalte von einer Maschine schreiben oder von einer ganzen Flotte von Textern? Google ist das egal, wie das Unternehmen am 8. Februar in einer Erklärung bestätigte. Was zählt, sei die Nützlichkeit der Inhalte – und dass die Inhalte nicht erstellt werden, um die Suchergebnisse zu manipulieren. Google schreibt:

"Die Ranking-Systeme von Google zielen darauf ab, originelle, qualitativ hochwertige Inhalte zu belohnen, die Qualitäten aufweisen, die wir E-E-A-T nennen: Expertise, Erfahrung, Autorität und Vertrauenswürdigkeit".

Google

Der Fokus liegt demnach ausschließlich auf der Qualität der Inhalte und nicht auf der Art und Weise, der Texterstellung.

In diesem Zusammenhang erwähnt Google explizit KI-generierte Inhalte und die Automatisierung von Inhalten:

"Automatisierung wird seit langem genutzt, um hilfreiche Inhalte wie Sportergebnisse, Wettervorhersagen und Transkripte zu generieren".

Google

KI, so Google, „hat die Fähigkeit, neue Ebenen des Ausdrucks und der Kreativität voranzutreiben und als entscheidendes Werkzeug zu dienen, um Menschen bei der Erstellung großartiger Inhalte für das Web zu unterstützen“.

Februar 2023: Google präsentiert Bard als Antwort auf ChatGPT

Nachdem einige Leute und sogar SEO-Experten erklärt haben, dass ChatGPT den Niedergang der größten Suchmaschine der Welt einläutet, hat Google seine Antwort auf ChatGPT veröffentlicht: Bard. Dessen Basis ist LaMDA, Googles großes Sprachmodell.

Sundar Pichai, CEO von Google und Alphabet, veröffentlichte ein Statement zum Start von Bard und beschreibt es als „einen experimentellen KI-Dienst für Konversationen”.

Zunächst ist Bard nur für “getreue Leser“ verfügbar, soll aber in wenigen Wochen der Allgemeinheit zur Verfügung stehen. Wie Bard funktionieren wird, demonstriert Google in dieser Darstellung:

Wie ChatGPT und GPT-3 stützt sich auch Bard für die Textgenerierung auf riesige Textmengen, die im Internet verfügbar sind. Das bedeutet, dass das Programm Informationen aus dem Web zieht, um Nutzern so ihre Fragen zu beantworten.

Es bleibt abzuwarten, wie Bard die Suchmaschine Google verändern wird und ob Content Creator das Nachsehen haben werden. Denn einige Experten befürchten, dass es den informational search traffic für Websites drastisch reduzieren wird.

Januar 2023: Google bekräftigt Richtlinien für KI-generierte Inhalte

Mit der Veröffentlichung und dem Hype um ChatGPT hat Google seine Richtlinien zu automatisiert erstellten Texten erneut bekräftigt. Anstoß war aber das Finanzdienstleistungsunternehmen Bankrate, wie seoroundtable.com berichtet. Warum? Bankrate nutzt offensiv KI für die Erstellung von Inhalten. Und sie sind damit in Suchmaschinen wie Google sehr erfolgreich. Das läuft so gut, dass sich Sistrix eingehend mit den hohen Rankings der KI-Inhalte beschäftigt.

Google hat daraufhin eine Erklärung über die Bewertung automatisiert erstellter Inhalte abgegeben:

Zudem stellte das Unternehmen klar, dass automatisierte Inhalte nicht per se ein Problem darstellen:

Wie bereits bei der Frage zur KI erwähnt, verstoßen Inhalte, die primär für das Ranking in Suchmaschinen erstellt werden, unabhängig davon, wie sie zustande kommen, gegen unsere Richtlinien. Wenn die Inhalte hilfreich sind und in erster Linie für Menschen erstellt werden, ist das kein Problem.”Google

Wie bewertet Google automatisierte Texte?

Eine gewisse Aufregung gab es, als Google Manager John Müller Anfang April 2022 in einem Hangout zu Googles Haltung bezüglich AI-generiertem Content gefragt wurde. Seine Aussage war:

Wir betrachten AI-generierten Content als Verstoß gegen Webmaster-Richtlinien“.Google Manager John Müller

Das wurde vielfach als allgemeine Ablehnung von automatisierten Texten verstanden. Doch die Google Webmaster Richtlinien zeigen deutlich: Die Haltung von Google gegenüber automatisierten Texten hat sich nicht geändert.

Google Webmaster Richtlinien: Bestraft wird nach wie vor die manipulative Absicht

In den Webmaster-Richtlinien, heißt es, dass automatisierte Texte dann ein Problem sind, wenn sie eine manipulative Absicht haben und nicht dafür erstellt wurden, Nutzern einen Mehrwert zu bieten.

„Wenn Suchrankings manipuliert werden sollen und Inhalte nicht dazu gedacht sind, Nutzern zu helfen, kann Google entsprechende Maßnahmen bezüglich dieser Inhalte ergreifen.”

Die hier gemeinten Maßnahmen sind manueller Art, die eine Prüfung durch einen Menschen erfordern und keine automatisierten Abstrafungen im Ranking.

Schlechte Inhalte und Spam sind das Problem, nicht die Automatisierung an sich

Google hat also im Augenblick nicht die Absicht, auf technischem Weg automatisierten Inhalt zu erkennen. Vielmehr nutzt die Suchmaschine für diese Art von Texten die inhaltlichen und formalen Spam-Kriterien, wie sie auch für handgeschriebene Texte gelten.

Tatsächlich wäre es zwar technisch möglich, Texte zu identifizieren, die von großen Sprachmodellen erzeugt wurden, nicht aber Texte, die von Data-to-Text Lösungen wie AX Semantics geniert wurden. Nur die herkömmlichen Spam-Indizien, wie eben schlechte sprachliche Qualität oder inhaltsloser Sprachmüll, könnten hier erkannt werden. Für Texte, die mit der Ausrichtung auf den User-Mehrwert generiert werden, wie es z.B. auf Produktbeschreibungen oder automatisierte News und Wettertexte zutrifft, besteht keine Gefahr für eine Google-Abstrafung. Auch das gleichzeitige Veröffentlichen großer Textmengen toleriert Google, solange es sich eben nicht um Spam handelt.

Welche automatisierten Inhalte sind für Google verdächtig?

Quelle: Google Webmaster Richtlinien Automatisierte Texte

- sinnfreier Text, in dem Schlüsselwörter verteilt sind

- automatisiert übersetzte Texte ohne Prüfung oder zugrundeliegendes Regelwerk

- extrem einfacher automatisierter Text auf Basis von Markov-Ketten oder mit Techniken der Synonymisierung oder Verschleierung

- Inhalte, die aus verschiedenen Webseiten zusammengefügt werden ohne ausreichenden Mehrwert

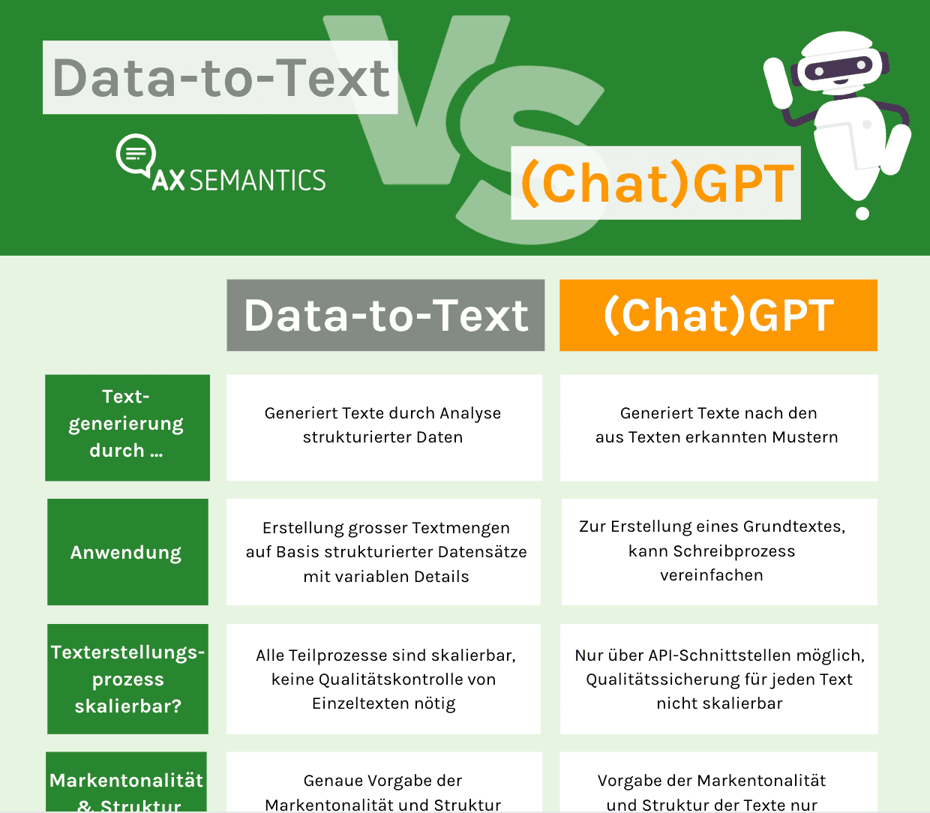

Grund für die aufkommende Diskussion: AI-Hype durch ChatGPT und GPT-3-Tools, die keinen regelbasierten Ansatz haben

Aufgekommen ist die aktuelle Diskussion aufgrund der vielfachen Nutzung von neuen GPT-Tools. Hierbei ist es nochmal wichtig, den Unterschied zwischen GPT und dem Data-to-Text-Ansatz von AX Semantics herauszustellen.

Lade das kostenlose pdf "Vergleich Data-to-Text vs. (Chat)GPT" herunter:

SEO, Data-to-Text und GPT

SEO-Expertin Miranda Miller vom Search Engine Journal, weist zurecht darauf hin, dass es sehr viele etablierte AI Content-Projekte gibt, die sehr guten Content haben (und damit gut bei Google ranken):

Die Associated Press hat 2014 damit begonnen, AI für die Generierung von Nachrichten einzusetzen. Der Einsatz von AI bei der Erstellung von Inhalten ist nicht neu, und der wichtigste Faktor dabei ist ihre intelligente Anwendung”.

SEO-Expertin Miranda Miller vom Search Engine Journal

Aber welche Software ist in puncto SEO verlässlicher: Data-to-Text oder GPT?

- Der mit Data-to-Text erstellte Text basiert auf Daten und Dateninterpretationen und nicht auf (teils sinnlosen) Verallgemeinerungen. Die Bedeutung des Inhalts – und damit der Nutzwert für Google – wird von den Nutzern bestimmt (über Logik, Geschichten und Auslöser). In den Texten steckt also Semantik, nicht nur korrekte Syntax.

- Bei Data-to-Text-Software überprüfen die Nutzer jede Entscheidung, die von KI-Komponenten im System getroffen wird. Sie sind also an allen entscheidenden Phasen der Texterstellung beteiligt.

- Manche Software kann feststellen, ob ein Text auf großen Sprachmodellen basiert, aber es gibt keine technische Möglichkeit, Daten-zu-Text-Inhalte zu erkennen.

Robert Weißgraeber

Robert Weissgraeber ist Co-CEO und Co-Gründer von AX Semantics, wo er u.a. sich mit Produktentwicklung beschäftigt als Managing Director tätig ist. Robert Weißgraeber ist ein gefragter Redner und Autor zu Themen wie agile Softwareentwicklung und Natural Language Generation (NLG) Technologien und Mitglied des Forbes Technology Council. Zuvor war er Chief Product Officer bei aexea und studierte Chemie an der Johannes Gutenberg-Universität und forschte an der Cornell University.